随着大数据时代的到来,处理海量数据的需求日益增长。ApacheSpark作为一种快速、可扩展的大数据处理引擎,受到了广泛的关注和应用。本文将深入探讨Spark的需求和发展趋势,以帮助读者更好地理解和应用Spark技术。

1.Spark的背景及其在大数据处理中的地位

-介绍Spark的起源和发展,以及其在大数据处理中的重要地位。

2.Spark的核心特性及优势

-解释Spark的核心特性,如内存计算、弹性分布式数据集(RDD)等,并探讨这些特性带来的优势。

3.大数据场景下Spark的需求

-分析大数据场景下对于处理速度、可扩展性和容错性的需求,以及Spark是如何满足这些需求的。

4.Spark与传统批处理技术的比较

-对比Spark与传统批处理技术(如HadoopMapReduce),分析其优劣和适用场景。

5.实时数据处理中的Spark需求

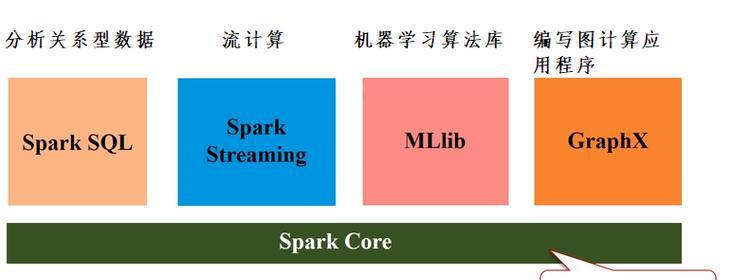

-探讨实时数据处理对于低延迟、高吞吐量和容错性的需求,并介绍SparkStreaming和StructuredStreaming等组件。

6.大规模图计算中的Spark需求

-分析大规模图计算对于分布式计算、图算法支持和可伸缩性的需求,以及Spark如何满足这些需求。

7.机器学习与人工智能中的Spark需求

-讨论机器学习和人工智能领域对于分布式计算、大规模数据处理和模型训练的需求,以及Spark的机器学习库(MLlib)的应用。

8.数据可视化与交互分析中的Spark需求

-探讨数据可视化和交互分析对于快速响应、可视化展示和交互性的需求,以及Spark如何支持这些需求。

9.多种数据存储格式与Spark的兼容性需求

-分析多种数据存储格式(如Parquet、Avro等)对于数据压缩、查询效率和数据兼容性的需求,以及Spark对这些格式的兼容性。

10.Spark的可扩展性与集群管理需求

-探讨在大规模数据处理场景下,对于横向扩展、资源管理和集群部署的需求,以及Spark如何支持这些需求。

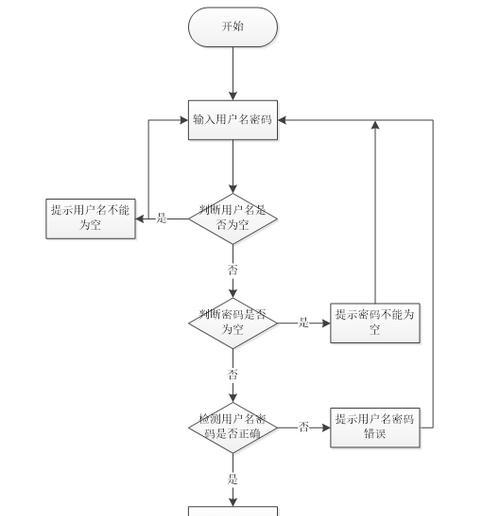

11.安全性与数据隐私保护的Spark需求

-讨论对于数据安全性、用户身份验证和数据隐私保护的需求,以及Spark如何提供相应的安全特性。

12.Spark生态系统的需求与发展趋势

-介绍Spark生态系统的各种组件和工具,以及其与其他大数据技术的整合需求和发展趋势。

13.Spark在不同行业中的应用需求

-探讨不同行业对于Spark的应用需求,如金融、电商、物流等,并介绍相应的应用案例。

14.Spark未来发展的需求与挑战

-分析未来对于Spark的需求和挑战,如更高的性能要求、更复杂的算法支持等,并展望Spark未来的发展方向。

15.

-本文对于Spark需求与发展趋势的探讨,强调Spark作为一种领先的大数据处理技术,在不同场景下都有广泛的应用前景。同时也提醒读者需要关注未来Spark技术的发展和变化。

本文深入探讨了Spark的需求和发展趋势,从各个角度探讨了Spark在不同场景下的应用需求,并展望了其未来的发展方向。Spark作为一种快速、可扩展的大数据处理引擎,将继续在大数据领域发挥重要作用,为解决各种大数据处理问题提供强有力的解决方案。